【 使用环境 】生产环境

【 OB or 其他组件 】OceanBase 社区版

【 使用版本 】4.2.5.2-102010012025022610

【问题描述】OBServer 里经常有内存分配报错的日志。

【复现路径】问题出现前后相关操作

【附件及日志】推荐使用OceanBase敏捷诊断工具obdiag收集诊断信息,详情参见链接(右键跳转查看):

【备注】基于 LLM 和开源文档 RAG 的论坛小助手已开放测试,在发帖时输入 [@论坛小助手] 即可召唤小助手,欢迎试用!

【告警信息】

告警概述:alarm_template_id=0:ob_cluster=obrs-1711351485:host=10.*.*.36 OBServer alloc_oops

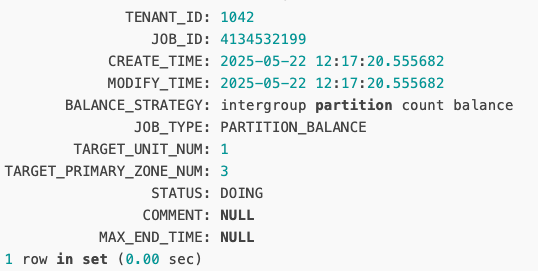

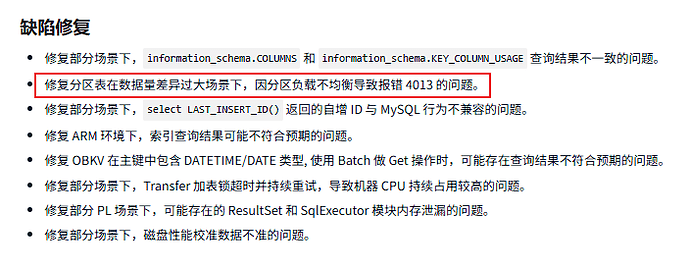

告警详情:[OBServer alloc_oops] 集群:obrs,主机:10.*.*.36,日志类型:observer,日志文件:/home/admin/oceanbase/log/observer.log,日志级别:WARN,关键字=alloc.*OOPS,错误码=4013,日志详情=[2025-06-12 09:04:25.985509] WARN [LIB] common_realloc (ob_tenant_ctx_allocator.cpp:544) [56524][T1042_TBalance][T1042][YB420A0A0A24-000631AF9255FE24-0-0] [lt=47][errcode=-4013] [OOPS]: alloc failed reason is that single alloc size large than 4G is not allowed(alloc_size: 8321499136)。

查看节点 日志,能看到信息也不多。

[2025-04-12 22:09:26.831448] WARN [LIB] common_realloc (ob_tenant_ctx_allocator.cpp:544) [56524][T1042_TBalance][T1042][YB420A0A0A24-000631AF9255F7C6-0-0] [lt=49][errcode=-4013] [OOPS]: alloc failed reason is that single alloc size large than 4G is not allowed(alloc_size: 8321499136)

[52651]OB_MALLOC COST TOO MUCH TIME, cost_time=320179, tenant_id=1008, label=LSMetaFile, ctx_id=0, prio=0, size=2101248, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=320174], seq:[0]

[53788]OB_MALLOC COST TOO MUCH TIME, cost_time=294202, tenant_id=1014, label=LSMetaFile, ctx_id=0, prio=0, size=2101248, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=294198], seq:[0]

[54287]OB_MALLOC COST TOO MUCH TIME, cost_time=387501, tenant_id=500, label=ObFuture, ctx_id=0, prio=0, size=216, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=387498], seq:[0]

[2025-04-12 23:03:35.901777] WARN [LIB] common_realloc (ob_tenant_ctx_allocator.cpp:544) [56524][T1042_TBalance][T1042][YB420A0A0A24-000631AF9255F7C7-0-0] [lt=50][errcode=-4013] [OOPS]: alloc failed reason is that single alloc size large than 4G is not allowed(alloc_size: 8321499136)

[53080]OB_MALLOC COST TOO MUCH TIME, cost_time=849401, tenant_id=500, label=ObFuture, ctx_id=0, prio=0, size=216, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=849399], seq:[0]

[2025-04-12 23:55:21.355684] WARN [LIB] common_realloc (ob_tenant_ctx_allocator.cpp:544) [56524][T1042_TBalance][T1042][YB420A0A0A24-000631AF9255F7C8-0-0] [lt=48][errcode=-4013] [OOPS]: alloc failed reason is that single alloc size large than 4G is not allowed(alloc_size: 8321499136)

[53833]OB_MALLOC COST TOO MUCH TIME, cost_time=849860, tenant_id=500, label=ObFuture, ctx_id=0, prio=0, size=216, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=849858], seq:[0]

[2025-04-13 00:48:08.643299] WARN [LIB] common_realloc (ob_tenant_ctx_allocator.cpp:544) [56524][T1042_TBalance][T1042][YB420A0A0A24-000631AF9255F7C9-0-0] [lt=51][errcode=-4013] [OOPS]: alloc failed reason is that single alloc size large than 4G is not allowed(alloc_size: 8321499136)

[54193]OB_MALLOC COST TOO MUCH TIME, cost_time=370258, tenant_id=1016, label=LSMetaFile, ctx_id=0, prio=0, size=2101248, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=370255], seq:[0]

[51985]OB_MALLOC COST TOO MUCH TIME, cost_time=824787, tenant_id=1015, label=CoStack, ctx_id=8, prio=1, size=515136, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=824780], seq:[0]

[53411]OB_MALLOC COST TOO MUCH TIME, cost_time=384376, tenant_id=1012, label=LSMetaFile, ctx_id=0, prio=0, size=2101248, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=384372], seq:[0]

[55931]OB_MALLOC COST TOO MUCH TIME, cost_time=416621, tenant_id=500, label=ObFuture, ctx_id=0, prio=0, size=216, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=416619], seq:[0]

[53439]OB_MALLOC COST TOO MUCH TIME, cost_time=160369, tenant_id=1012, label=SqcHandlerParam, ctx_id=0, prio=0, size=3976248, owner: ObMalloc, click_count: 1, time dist:[ALLOC_CHUNK_END=1], seq:[0]