感谢大佬,麻烦看看。

{

“service_port”: 2983,

“encode_threadpool_size”: 8,

“encode_queue_size”: 20000,

“max_packet_bytes”: 67108864,

“record_queue_size”: 20000,

“read_timeout_us”: 2000000,

“read_fail_interval_us”: 1000000,

“read_wait_num”: 20000,

“send_timeout_us”: 2000000,

“send_fail_interval_us”: 1000000,

“check_quota_enable”: false,

“check_clog_enable”: true,

“command_timeout_s”: 10,

“log_quota_size_mb”: 5120,

“log_quota_day”: 7,

“log_gc_interval_s”: 43200,

“log_level”: 2,

“log_flush_strategy”: 1,

“log_flush_level”: 2,

“log_flush_period_s”: 1,

“log_max_file_size_mb”: 1024,

“log_retention_h”: 360,

“oblogreader_path_retain_hour”: 168,

“oblogreader_lease_s”: 300,

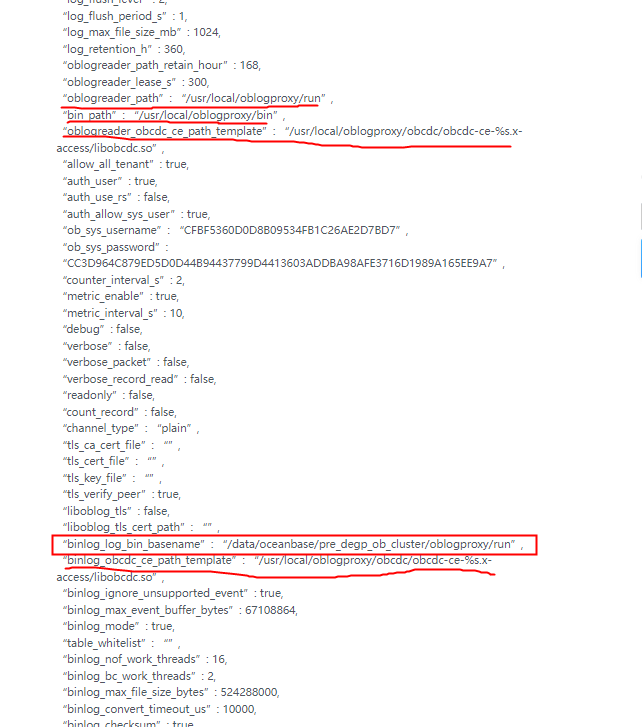

“oblogreader_path”: “/usr/local/oblogproxy/run”,

“bin_path”: “/usr/local/oblogproxy/bin”,

“oblogreader_obcdc_ce_path_template”: “/usr/local/oblogproxy/obcdc/obcdc-ce-%s.x-access/libobcdc.so”,

“allow_all_tenant”: true,

“auth_user”: true,

“auth_use_rs”: false,

“auth_allow_sys_user”: true,

“ob_sys_username”: “CFBF5360D0D8B09534FB1C26AE2D7BD7”,

“ob_sys_password”: “CC3D964C879ED5D0D44B94437799D4413603ADDBA98AFE3716D1989A165EE9A7”,

“counter_interval_s”: 2,

“metric_enable”: true,

“metric_interval_s”: 10,

“debug”: false,

“verbose”: false,

“verbose_packet”: false,

“verbose_record_read”: false,

“readonly”: false,

“count_record”: false,

“channel_type”: “plain”,

“tls_ca_cert_file”: “”,

“tls_cert_file”: “”,

“tls_key_file”: “”,

“tls_verify_peer”: true,

“liboblog_tls”: false,

“liboblog_tls_cert_path”: “”,

“binlog_log_bin_basename”: “/data/oceanbase/pre_degp_ob_cluster/oblogproxy/run”,

“binlog_obcdc_ce_path_template”: “/usr/local/oblogproxy/obcdc/obcdc-ce-%s.x-access/libobcdc.so”,

“binlog_ignore_unsupported_event”: true,

“binlog_max_event_buffer_bytes”: 67108864,

“binlog_mode”: true,

“table_whitelist”: “”,

“binlog_nof_work_threads”: 16,

“binlog_bc_work_threads”: 2,

“binlog_max_file_size_bytes”: 524288000,

“binlog_convert_timeout_us”: 10000,

“binlog_checksum”: true,

“binlog_heartbeat_interval_us”: 1000000,

“binlog_gtid_display”: true,

“binlog_ddl_convert”: true,

“binlog_memory_limit”: “3G”,

“binlog_working_mode”: “storage”,

“binlog_recover_backup”: true,

“wait_rotate_ready_max_try”: 1000,

“telemetry_url”: “https://openwebapi.oceanbase.com”,

“telemetry_enabled”: true

}