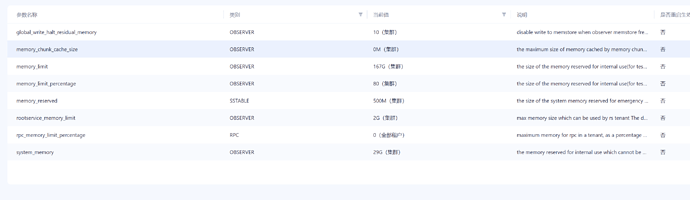

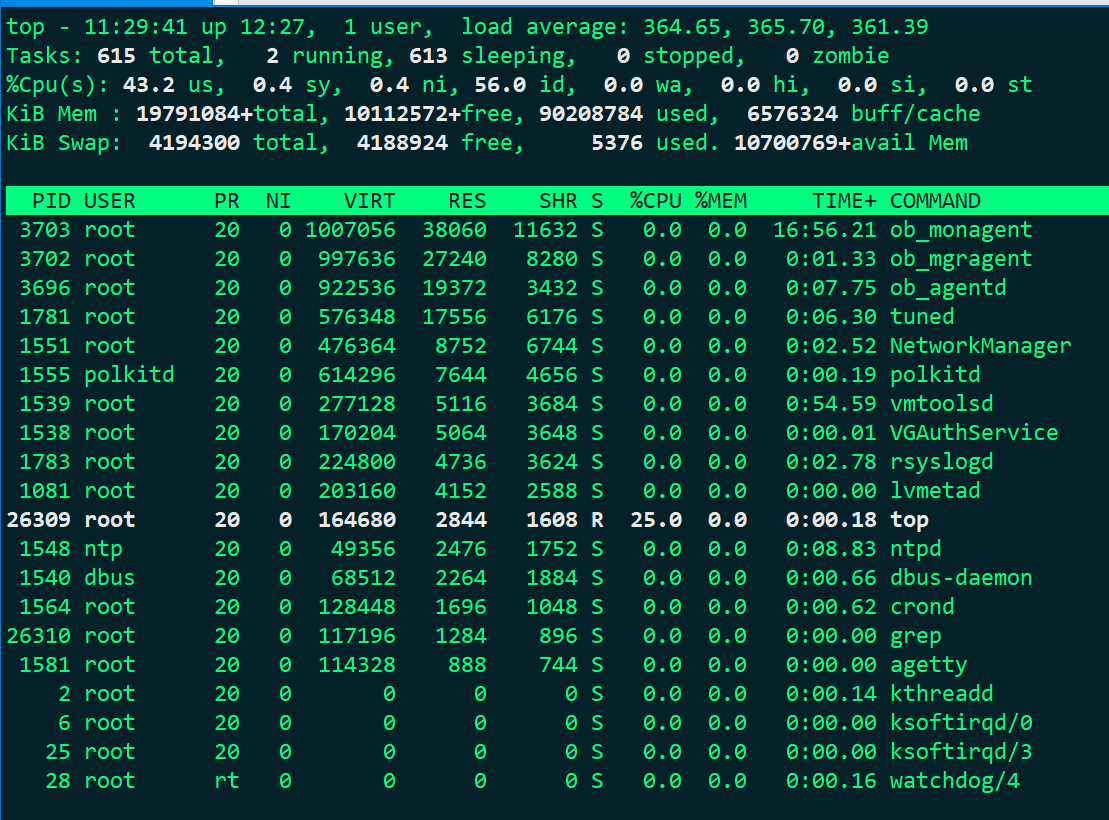

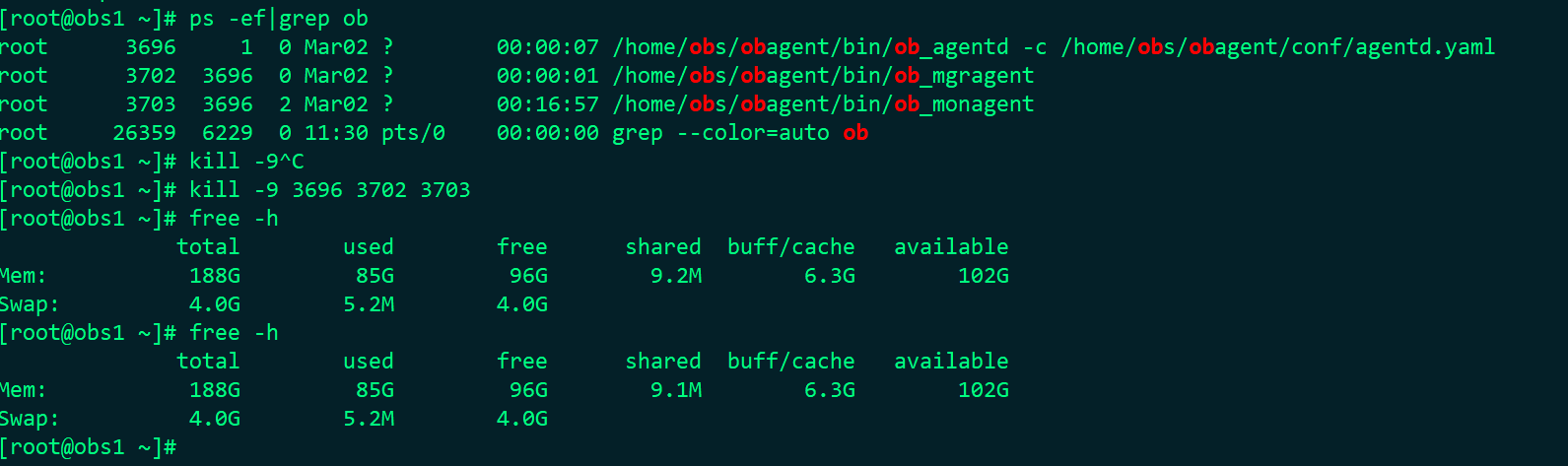

128G 内存的机器 OB 应该能很好的运行。估计是内存参数哪里设置有问题。

可以先发一下下面 SQL看看资源情况。

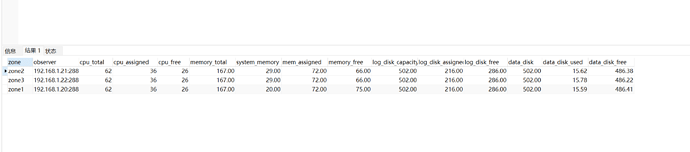

select zone,concat(SVR_IP,':',SVR_PORT) observer,

cpu_capacity_max cpu_total,cpu_assigned_max cpu_assigned,

cpu_capacity-cpu_assigned_max as cpu_free,

round(memory_limit/1024/1024/1024,2) as memory_total,

round((memory_limit-mem_capacity)/1024/1024/1024,2) as system_memory,

round(mem_assigned/1024/1024/1024,2) as mem_assigned,

round((mem_capacity-mem_assigned)/1024/1024/1024,2) as memory_free,

round(log_disk_capacity/1024/1024/1024,2) as log_disk_capacity,

round(log_disk_assigned/1024/1024/1024,2) as log_disk_assigned,

round((log_disk_capacity-log_disk_assigned)/1024/1024/1024,2) as log_disk_free,

round((data_disk_capacity/1024/1024/1024),2) as data_disk,

round((data_disk_in_use/1024/1024/1024),2) as data_disk_used,

round((data_disk_capacity-data_disk_in_use)/1024/1024/1024,2) as data_disk_free

from gv$ob_servers;

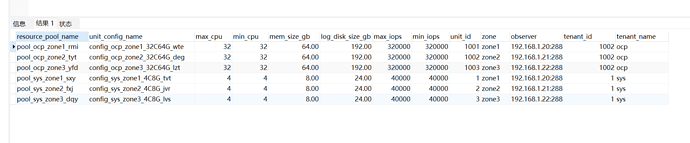

select t1.name resource_pool_name, t2.`name` unit_config_name,

t2.max_cpu, t2.min_cpu,

round(t2.memory_size/1024/1024/1024,2) mem_size_gb,

round(t2.log_disk_size/1024/1024/1024,2) log_disk_size_gb, t2.max_iops,

t2.min_iops, t3.unit_id, t3.zone, concat(t3.svr_ip,':',t3.`svr_port`) observer,

t4.tenant_id, t4.tenant_name

from __all_resource_pool t1

join __all_unit_config t2 on (t1.unit_config_id=t2.unit_config_id)

join __all_unit t3 on (t1.`resource_pool_id` = t3.`resource_pool_id`)

left join __all_tenant t4 on (t1.tenant_id=t4.tenant_id)

order by t1.`resource_pool_id`, t2.`unit_config_id`, t3.unit_id;

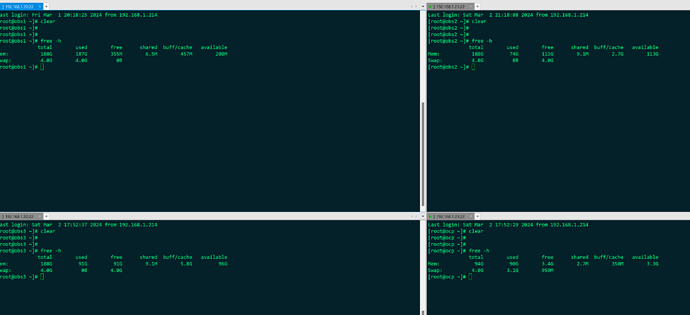

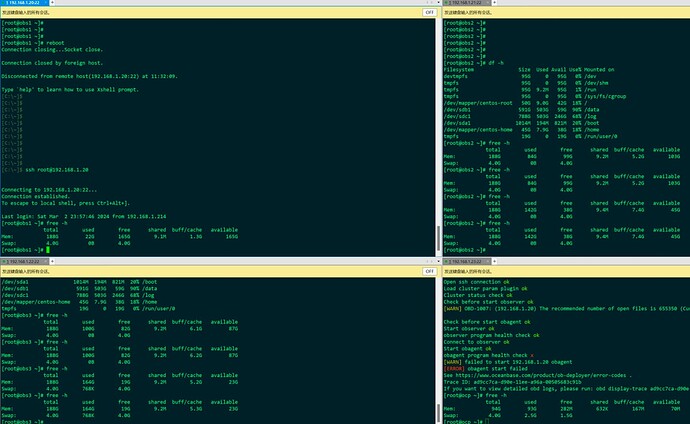

然后发一下每个机器的 内存使用情况

free -h