根据workshop(https://gitee.com/oceanbase-devhub/ai-workshop-2024#2-安装依赖)

其中:

poetry run python embed_docs.py --doc_base . --table_name my_table --echo

看起来应该是一个md文章对应数据库一条 数据库表my_table中的一条记录。

2024-10-16 03:17:13,439 INFO sqlalchemy.engine.Engine

CREATE TABLE my_table (

id VARCHAR(4096) NOT NULL,

embedding VECTOR(1024),

document LONGTEXT,

metadata JSON,

component_code INTEGER NOT NULL,

PRIMARY KEY (id, component_code)

)

...

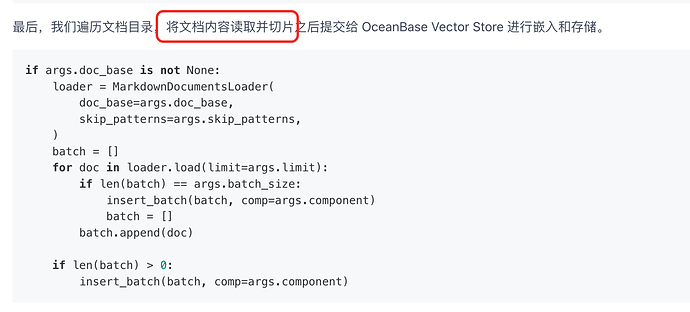

那么我想请教一下是不是就不再需要之前工具(dify、fastgpt、dbgpt等)的chunk成更小单元的过程了(如400个字)。是不是对于用户来说只需要把一篇文章(无论大小),全部放到表一条记录中即可?