【 使用环境 】测试环境

【备注】基于 LLM 和开源文档 RAG 的论坛小助手已开放测试,在发帖时输入 [@论坛小助手 ] 即可召唤小助手,欢迎试用!

1 个赞

论坛小助手

2025 年5 月 28 日 17:45

#3

根据您提供的信息,问题可能与 obshell 的启动失败有关。以下是针对您问题的详细分析和解决建议:

部署提示失败但服务运行

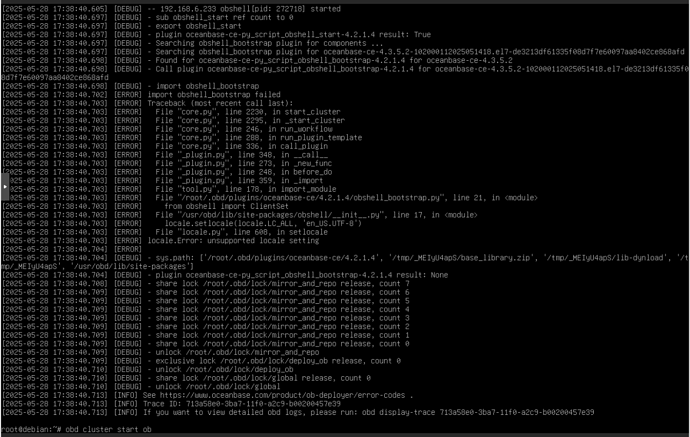

节点重启后无法启动 obd cluster start ob 命令无法启动集群,提示 import obshell_bootstrap failed。这表明 obshell 的启动过程中存在问题。

错误日志分析

import obshell_bootstrap failed 表明 obshell 的启动脚本加载失败。

日志中还提到 setlocale 出现问题,这可能与系统的区域设置(locale)不正确有关。

如果问题仍然存在,请查看详细的 obd 日志以获取更多信息:obd log -f

根据日志中的具体错误信息进一步排查。

生产模式配置

您提到这是测试环境,请确保 production_mode 配置为 false,以避免严格的检查限制。参考文档片段 2 和 9。

内核参数检查

确保操作系统的内核参数符合 OceanBase 的推荐配置。如果测试环境中无法修改内核参数,可以通过将 production_mode 设置为 false 来跳过检查。

版本兼容性

您使用的是 OceanBase 4.5.3.2 版本,请确保 obd 的版本与之兼容。参考文档片段 6 和 8。

根据文档库中的信息,问题的主要原因可能是系统 locale 配置不正确或 obshell 的依赖项缺失。通过修复 locale、安装依赖项以及重新部署集群,应该可以解决此问题。如果问题仍未解决,请提供更详细的日志信息以便进一步分析。

更多信息请查看:

OceanBase 安装部署工具 V2.8.0 错误码 OceanBase 安装部署工具 V2.4.0 通过图形化界面部署 OCP 通过图形化界面变更组件 启动 obshell

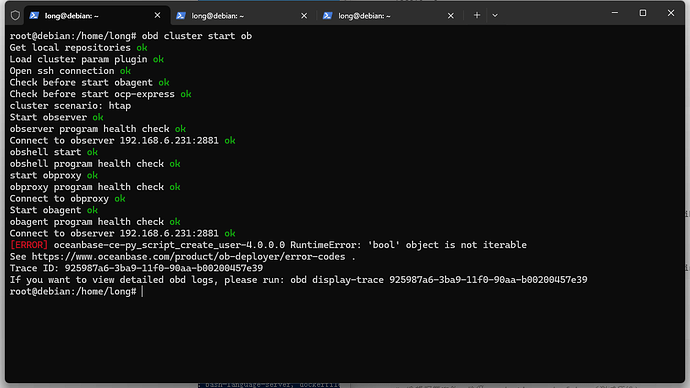

改好后,出现另外一个错误了:root@debian:/home/long# obd cluster start obhttps://www.oceanbase.com/product/ob-deployer/error-codes .

1 个赞

辞霜

2025 年5 月 28 日 18:05

#6

麻烦提供一份~/.obd/cluster/xxxx/yaml文件,obd 版本

2 个赞

是虚拟机

192.168.6.231

192.168.6.232

192.168.6.233

192.168.6.231

192.168.6.232

192.168.6.233

oceanbase-ce

192.168.6.231

192.168.6.232

192.168.6.233

oceanbase-ce

192.168.6.231

obagent

oceanbase-ce

obproxy-ce

root@debian:/home/long# cat /root/.obd/cluster/ob/inner_config.yaml

辞霜

2025 年5 月 29 日 09:40

#10

ocp-express当前不建议使用了 这边已经不进行维护了,节后就会下掉了。

您这边建议先部署ob集群还是先部署ocp呢? 先部署ob的话 ocp用4.3.5.2是否有影响?

辞霜

2025 年5 月 29 日 14:23

#12

直接可部署一台单节点ocp后续使用ocp进行ob安装部署比较方便

如果希望ocp也高可用呢?

辞霜

2025 年5 月 29 日 14:34

#15

和ob公用,

大致就是 先安装obd,然后obd部署全新环境的ocp,这个ocp把默认端口修改掉,然后使用ocp去部署ob集群,这个ob集群用默认端口。

不修改端口的话,ocp和ob共用同一个服务器,不就冲突了吗?因为ocp也有proxy和ob

辞霜

2025 年5 月 29 日 14:59

#19

ocp需要一台ob数据库来作为自己的metadb。所以该节点只能为ocp提供服务。

我理解的是:

ob节点

obproxy节点

辞霜

2025 年5 月 29 日 15:36

#21

ob不支持且不建议单节点多实例部署

您的意思是,ocp和ocp的metadb可以共用一个节点,但是业务的ob需要单独部署在其它节点上

辞霜

2025 年5 月 29 日 15:43

#23

是的,ocp可以管控多台集群。ocp具有监控告警 备份恢复 数据库启停运维等功能。功能很强大

1 个赞