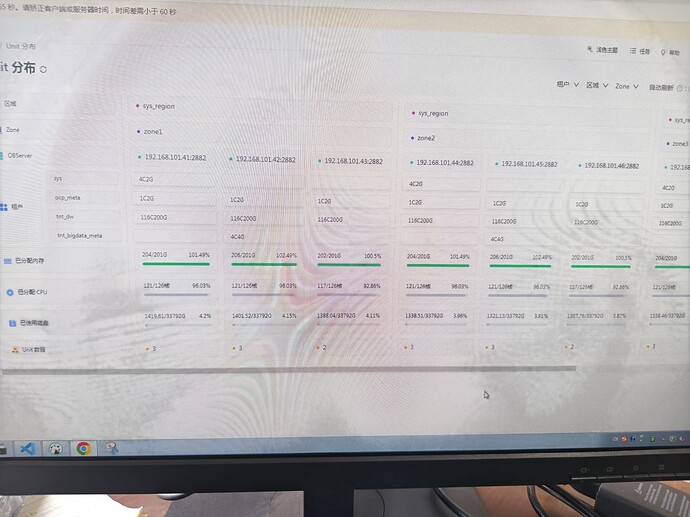

【 使用环境 】生产环境

【 obloader版本 】4.3.3-RELEASE

【 OceanBase使用版本 】4.3.4

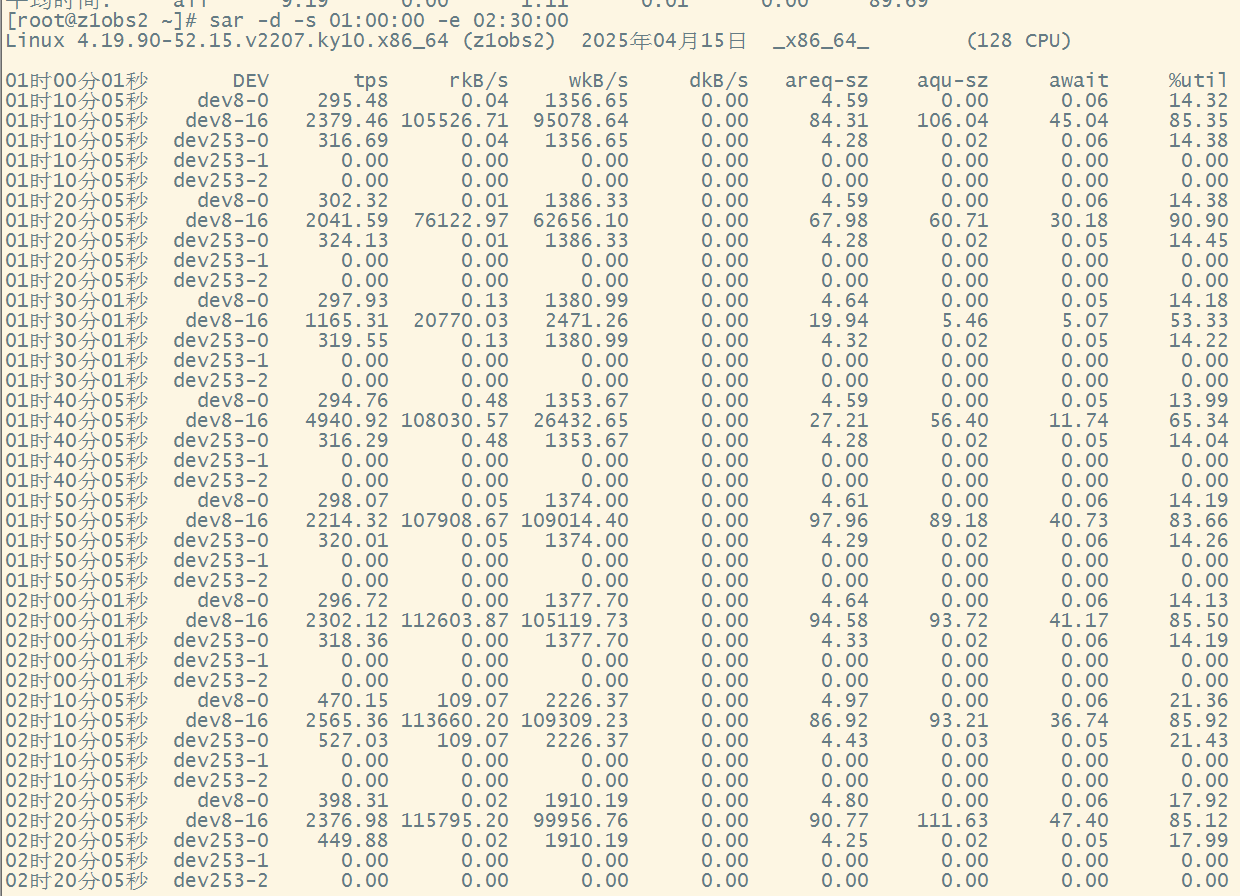

【问题描述】使用obloader旁路导入大量数据,运行脚本如下:

./obloader -h 192.168.101.51 -P 2883 -u dw@tnt_dw#obccc -t tnt_dw -c obccc -p ***** -D safe_net_dw \

--table dwd_call_details \

--auto-column-mapping \

--csv \

--tmp-path /data/load \

--thread 50 \

--parallel 50 \

--direct \

--rpc-port 2885 \

-f 'hdfs://192.168.101.36:8020/data/export/oceanbase_import/sub_folder_1/dwd_call_details?hdfs-site-file=/backup/hdfs-site.xml&core-site-file=/backup/core-site.xml'

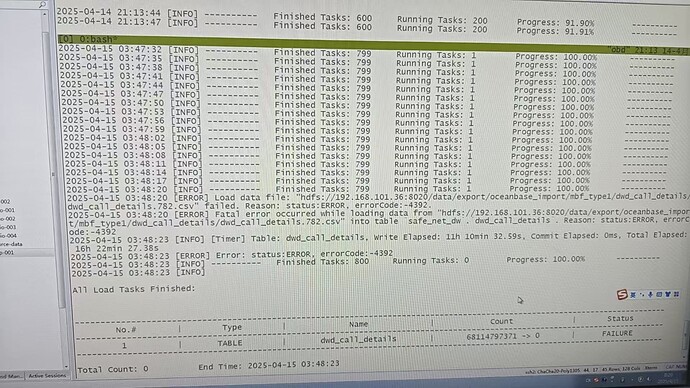

运行到最后的时候报错:Error: status:ERRoR,errorcode:-4392

【复现路径】无

【附件及日志】

【备注】最后单独导入dwd_ca1l details.782.csv文件是成功的。