【 使用环境 】 测试环境

【 OB or 其他组件 】

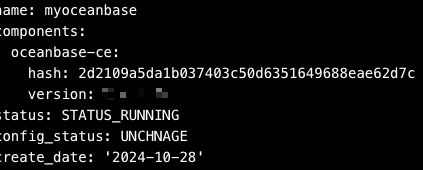

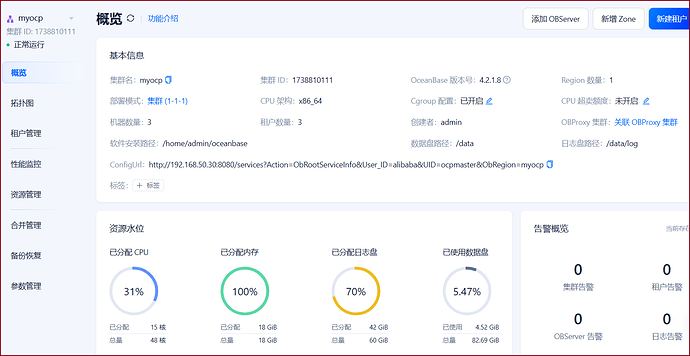

【 使用版本 】 ob 4.2.1.8 ocp 4.34

【问题描述】

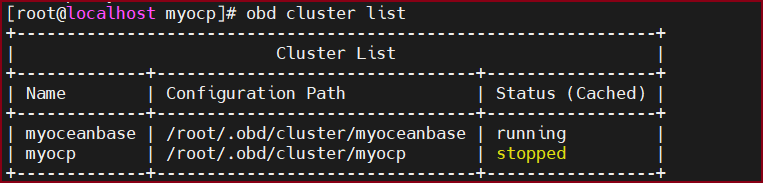

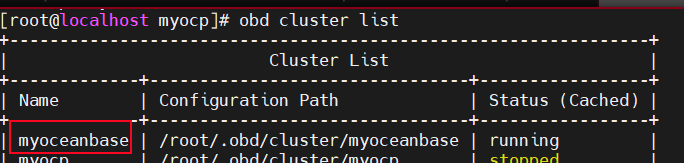

1、我在重启ocp主机后,显示myocp这个cluster状态是stoped

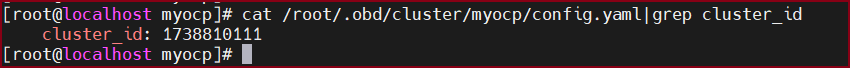

2、这个是myocp的cluster_id,与ocp中是一致的

3、但是这个时候使用 ocp的 obprxy 2883端口是可以连上cluster的

4、同时打开ocp 8080 页面是正常的

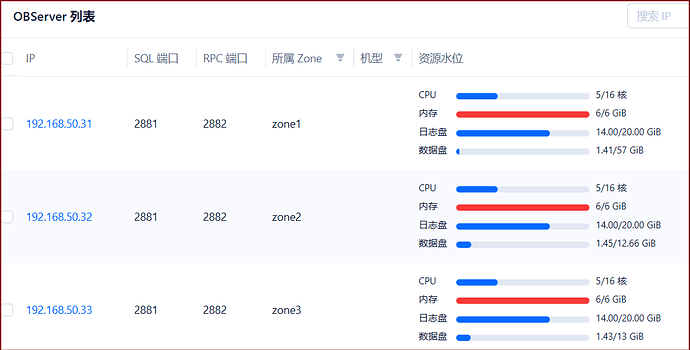

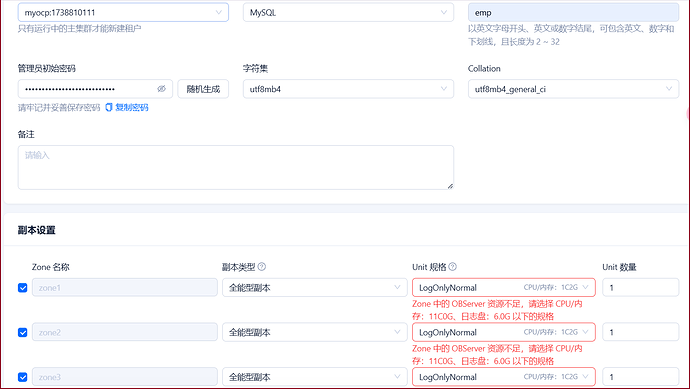

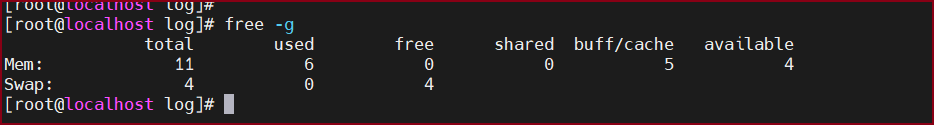

第二个问题,如何修改集群可分配内存。

看到上面图,每个observer显示是6G ,已分配100%,其实我每个observer 主机是12G内存,如何修改这个限制

请问是这个参数吗

global:

appname: myocp

。。。。。。。。。

memory_limit: 7G

datafile_size: 11G

system_memory: 1G

log_disk_size: 20G

cpu_count: 16

1 个赞

淇铭

#3

你搭建的ocp的元数据库是基于哪个ob集群搭建的

这个是 yaml文件么?如果是 你看的是哪个集群的yaml文件?

2 个赞

就是我这个observer只能看到6GB 但是其实我主机有12GB

1 个赞

我当时是选 使用全新的OB数据库来部署MetaDB 继而安装OCP

目前看的是 myocp 下面的 config.yaml

1 个赞

淇铭

#7

ocp和ob集群是分开的是么 ob集群1-1-1 ocp是单独一台服务器是么?

2 个赞

是的 ocp是单独的一台, 其他3个ob 是1-1-1

1 个赞

淇铭

#9

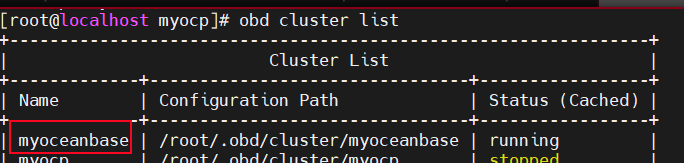

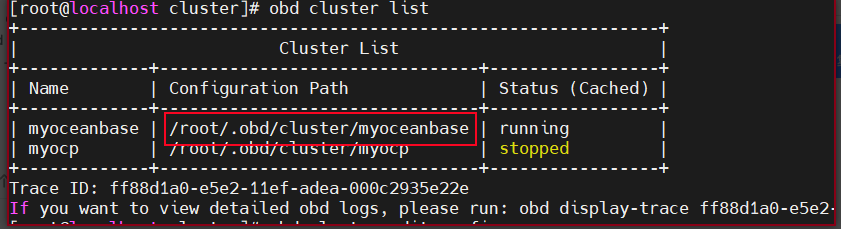

1、obd cluster list

2、obd cluster edit-config myocp --保存在文本里 提供一下 注意密码隐藏

3、 ps -ef | grep observer | grep -v grep --进程信息 截图看看

3 个赞

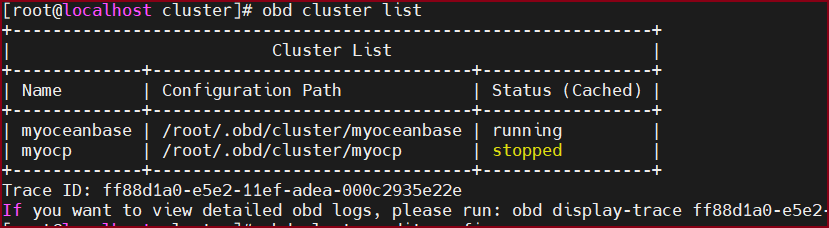

[root@localhost cluster]# obd cluster list

±---------------------------------------------------------------+

| Cluster List |

±------------±-------------------------------±----------------+

| Name | Configuration Path | Status (Cached) |

±------------±-------------------------------±----------------+

| myoceanbase | /root/.obd/cluster/myoceanbase | running |

| myocp | /root/.obd/cluster/myocp | stopped |

±------------±-------------------------------±----------------+

Trace ID: ff88d1a0-e5e2-11ef-adea-000c2935e22e

If you want to view detailed obd logs, please run: obd display-trace ff88d1a0-e5e2-11ef-adea-000c2935e22e

2、

user:

username: admin

password: !!

port: 22

oceanbase-ce:

version: 4.2.1.8

release: 108000022024072217.el7

package_hash: 499b676f2ede5a16e0c07b2b15991d1160d972e8

192.168.50.31:

zone: zone1

datafile_maxsize: 57G

datafile_next: 6G

192.168.50.32:

zone: zone2

datafile_maxsize: 20G

datafile_next: 2G

192.168.50.33:

zone: zone3

datafile_maxsize: 20G

datafile_next: 2G

servers:

- 192.168.50.31

- 192.168.50.32

- 192.168.50.33

global:

appname: myocp

root_password: ‘[b.8@i5Q+.6/UX3’

mysql_port: 2881

rpc_port: 2882

home_path: /home/admin/oceanbase

data_dir: /data/

redo_dir: /data/log

ocp_meta_tenant:

tenant_name: ocp_meta

max_cpu: 2.0

memory_size: 2G

ocp_meta_username: root

ocp_meta_password: ‘5!2y)!bWG?:’

ocp_meta_db: meta_database

ocp_monitor_tenant:

tenant_name: ocp_monitor

max_cpu: 2.0

memory_size: 2G

ocp_monitor_username: root

ocp_monitor_password: 5audzm4;%+HjvNEdZ

ocp_monitor_db: monitor_database

cluster_id: 1738810111

proxyro_password:

ocp_meta_tenant_log_disk_size: 8G

enable_syslog_wf: false

max_syslog_file_count: 4

production_mode: false

memory_limit: 11G

datafile_size: 11G

system_memory: 1G

log_disk_size: 20G

cpu_count: 16

obproxy-ce:

version: 4.3.2.0

package_hash: b7ae0af3860478f3caecaaec05bd67d0565e4021

release: 42.el7

servers:

- 192.168.50.30

global:

home_path: /home/admin/obproxy

prometheus_listen_port: 2884

listen_port: 2883

enable_obproxy_rpc_service: false

obproxy_sys_password:

skip_proxy_sys_private_check: true

enable_strict_kernel_release: false

enable_cluster_checkout: false

depends:

- oceanbase-ce

192.168.50.30:

proxy_id: 3954

client_session_id_version: 2

ocp-server-ce:

version: 4.3.4

package_hash: 14639bd559122ecd39aa5bbbfef6859dd8c39834

release: 20250114101305.el7

servers:

- 192.168.50.30

global:

home_path: /home/admin/ocp

soft_dir: /home/admin/software

log_dir: /home/admin/logs

ocp_site_url: http://192.168.50.30:8080

port: 8080

admin_password: ~*{Oh~

memory_size: 4G

manage_info:

machine: 10

depends:

- oceanbase-ce

- obproxy-ce

3 observer上跑的

[root@localhost log]# ps -eaf|grep observer|grep -v grep

admin 18705 1 99 Feb07 ? 2-02:56:37 /home/admin/oceanbase/bin/observer -p 2881 -P 2882 -z zone1 -n myocp -c 1738810111 -d /data/ -I 192.168.50.31 -o __min_full_resource_pool_memory=2147483648,enable_syslog_wf=False,max_syslog_file_count=4,memory_limit=7G,datafile_size=11G,system_memory=1G,log_disk_size=20G,cpu_count=16,datafile_maxsize=57G,datafile_next=6G

淇铭

#12

这个文件下面有个文件.data文件 可以vi修改 把状态值修改了就好了

/root/.obd/cluster/myocp/.data

你这个集群是删除了么?

2 个赞

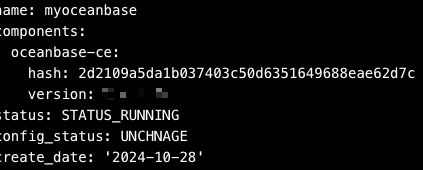

确实可以了,该了myocp .data 。

是的上面那个cluster我删除了,但是/root下的文件没删除,他obd似乎还能读到,可能需要手工删除文件

淇铭

#14

把这个文件删除就好了 因为是个隐藏文件 你估计没有找到

1 个赞

淇铭

#18

你先操作截图 具体看看你怎么操作的 或许是你操作的有问题 或者资源不足导致的

1 个赞