Elm

2024 年12 月 20 日 14:47

#1

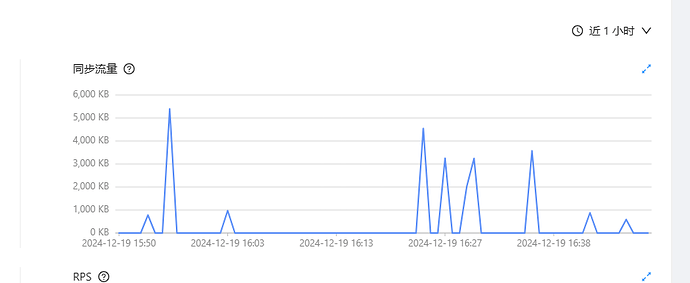

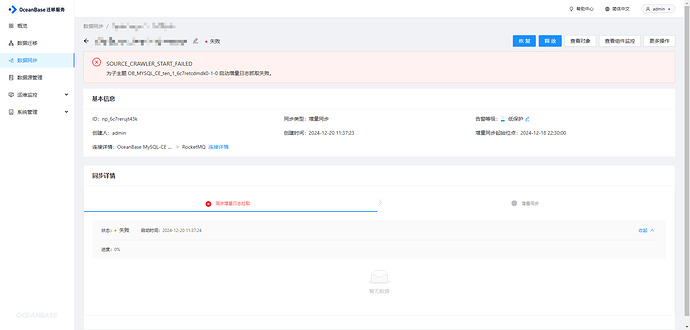

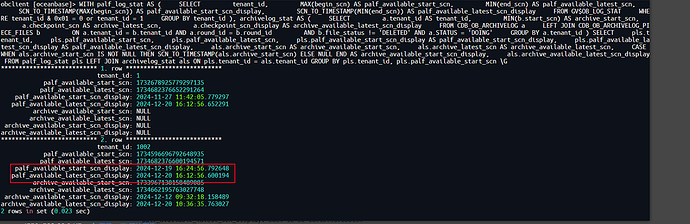

【 使用环境 】生产环境1、增量同步不稳定

2、重启OMS之后依旧不行

![1ac76afeddd33cf450646ad7bdbf3f2|690x276]

重启OMS之后依旧不行的日志 connector.log (40.7 KB)error.log (117 字节)libobcdc.7z (1.2 MB)

4 个赞

淇铭

2024 年12 月 20 日 15:28

#4

你查一下 这个进程ps -ef|grep oms-supervisor

4 个赞

Elm

2024 年12 月 20 日 15:32

#5

[root@localhost ~]# ps -ef|grep oms-supervisor

1000 17056 15715 4 14:00 pts/0 00:03:44 java -server -Xms2g -Xmx2g -Xmn1g -Xss1024k -verbose:gc -Xloggc:./log/gc.log -XX:+PrintGC -XX:+PrintGCDetails -XX:MetaspaceSize=256m -XX:CMSInitiatingOccupancyFraction=75 -XX:+UseCMSInitiatingOccupancyOnly -XX:+PrintGCTimeStamps -XX:+PrintGCDateStamps -XX:HeapDumpPath=/home/ds/supervisor -XX:+HeapDumpOnOutOfMemoryError -Dsun.reflect.inflationThreshold=0 -Dserver.port=9000 -DconfigDir=/u01/ds/supervisor/config/ -Dspring.main.allow-circular-references=true -Ddb2.jcc.charsetDecoderEncoder=3 -Doracle.jdbc.javaNetNio=false -jar ./bin/oms-supervisor.jar

1000 18420 15715 2 14:01 pts/0 00:02:06 java -server -Xms2g -Xmx2g -Xmn1g -Xss1024k -verbose:gc -Xloggc:./log/gc.log -XX:+PrintGC -XX:+PrintGCDetails -XX:MetaspaceSize=256m -XX:CMSInitiatingOccupancyFraction=75 -XX:+UseCMSInitiatingOccupancyOnly -XX:+PrintGCTimeStamps -XX:+PrintGCDateStamps -XX:HeapDumpPath=/home/ds/supervisor -XX:+HeapDumpOnOutOfMemoryError -Dsun.reflect.inflationThreshold=0 -Dserver.port=9000 -DconfigDir=/u01/ds/supervisor/config/ -Dspring.main.allow-circular-references=true -Ddb2.jcc.charsetDecoderEncoder=3 -Doracle.jdbc.javaNetNio=false -jar ./bin/oms-supervisor.jar

root 19785 22606 0 15:32 pts/0 00:00:00 grep --color=auto oms-supervisor

1000 30405 15715 2 14:04 pts/0 00:02:14 java -server -Xms2g -Xmx2g -Xmn1g -Xss1024k -verbose:gc -Xloggc:./log/gc.log -XX:+PrintGC -XX:+PrintGCDetails -XX:MetaspaceSize=256m -XX:CMSInitiatingOccupancyFraction=75 -XX:+UseCMSInitiatingOccupancyOnly -XX:+PrintGCTimeStamps -XX:+PrintGCDateStamps -XX:HeapDumpPath=/home/ds/supervisor -XX:+HeapDumpOnOutOfMemoryError -Dsun.reflect.inflationThreshold=0 -Dserver.port=9000 -DconfigDir=/u01/ds/supervisor/config/ -Dspring.main.allow-circular-references=true -Ddb2.jcc.charsetDecoderEncoder=3 -Doracle.jdbc.javaNetNio=false -jar ./bin/oms-supervisor.jar

4 个赞

淇铭

2024 年12 月 20 日 15:42

#6

你那这个几个进程 全部kill了

3 个赞

Elm

2024 年12 月 20 日 15:56

#7

日志要是归档了,store设置的起始同步位点在已归档时间之前,是否影响增量同步拉取数据

3 个赞

淇铭

2024 年12 月 20 日 16:06

#8

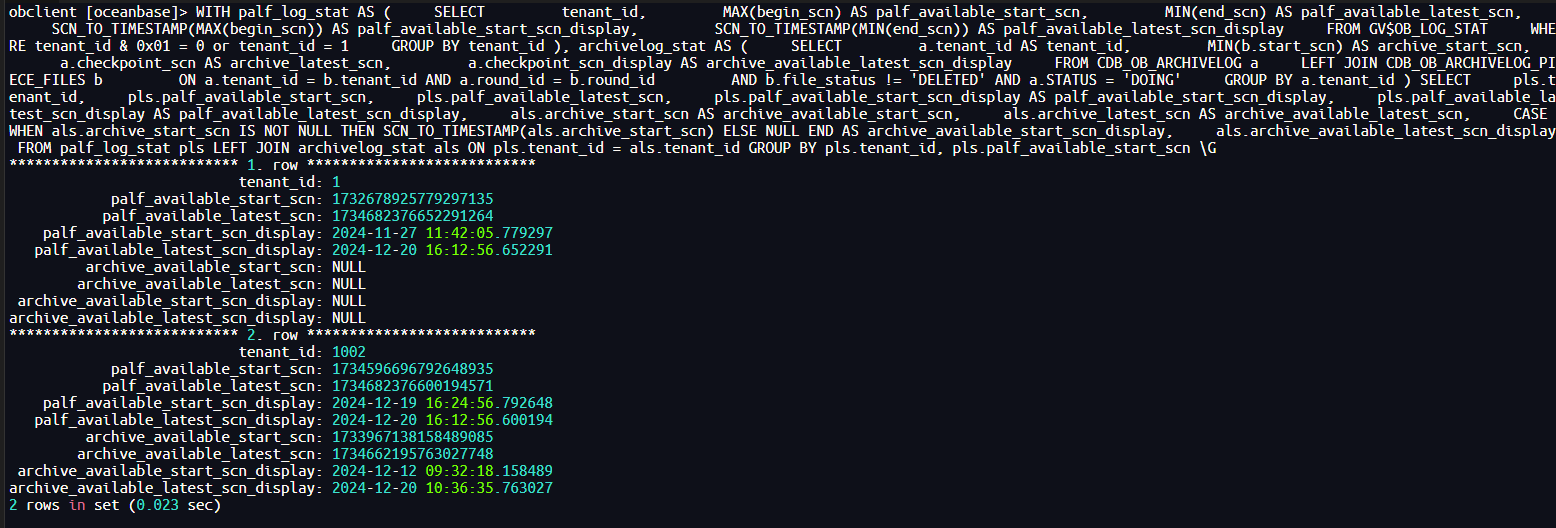

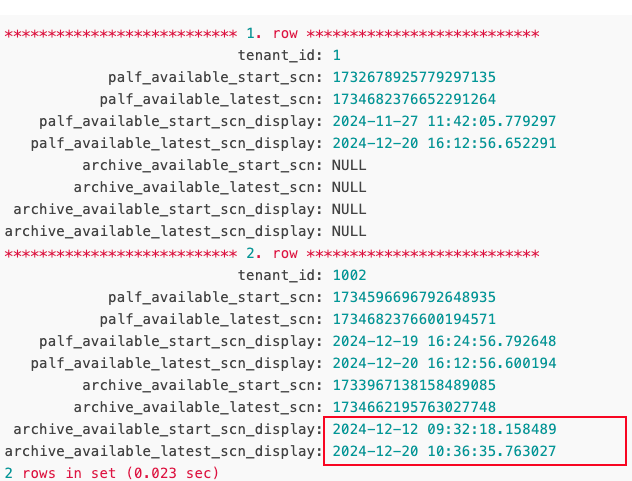

系统租户oceanbase库下执行如下查询SQL

2 个赞

Elm

2024 年12 月 20 日 16:13

#9

*************************** 1. row ***************************

tenant_id: 1

palf_available_start_scn: 1732678925779297135

palf_available_latest_scn: 1734682376652291264

palf_available_start_scn_display: 2024-11-27 11:42:05.779297

palf_available_latest_scn_display: 2024-12-20 16:12:56.652291

archive_available_start_scn: NULL

archive_available_latest_scn: NULL

archive_available_start_scn_display: NULL

archive_available_latest_scn_display: NULL

*************************** 2. row ***************************

tenant_id: 1002

palf_available_start_scn: 1734596696792648935

palf_available_latest_scn: 1734682376600194571

palf_available_start_scn_display: 2024-12-19 16:24:56.792648

palf_available_latest_scn_display: 2024-12-20 16:12:56.600194

archive_available_start_scn: 1733967138158489085

archive_available_latest_scn: 1734662195763027748

archive_available_start_scn_display: 2024-12-12 09:32:18.158489

archive_available_latest_scn_display: 2024-12-20 10:36:35.763027

2 rows in set (0.023 sec)

2 个赞

淇铭

2024 年12 月 20 日 16:28

#10

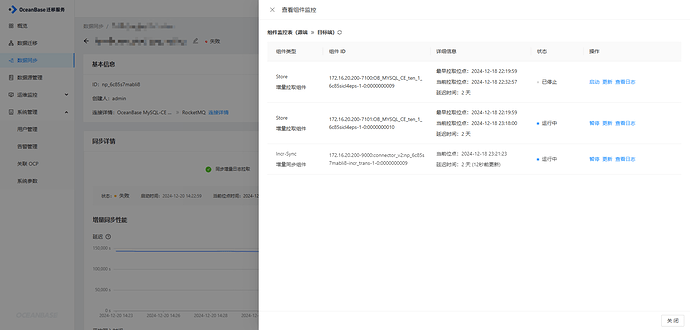

启动位点以及距离启动位点最近的数据字典的snapshot_scn需要位于这个区间就可以 你看看是不是

2 个赞

Elm

2024 年12 月 20 日 16:31

#11

如何拉取已归档的?

2 个赞

刘彻

2024 年12 月 20 日 18:16

#13

开始位点如果不在clog中,默认就会从归档中取,如果归档也没有就会报错

1 个赞

Elm

2024 年12 月 20 日 18:24

#14

现在需要的开始位点【2024-12-18 22:22:00】,在已归档日志中

[root@localhost ~]# ll /data/nfs_server/backup/archive/

总用量 8

drwx------. 2 nfsnobody nfsnobody 53 12月 12 09:31 check_file

-rw-------. 1 nfsnobody nfsnobody 148 12月 12 09:31 format.obbak

drwx------. 5 nfsnobody nfsnobody 220 12月 13 09:34 piece_d1001r1p1

drwx------. 5 nfsnobody nfsnobody 220 12月 14 09:34 piece_d1001r1p2

drwx------. 5 nfsnobody nfsnobody 220 12月 15 09:34 piece_d1001r1p3

drwx------. 5 nfsnobody nfsnobody 220 12月 16 09:34 piece_d1001r1p4

drwx------. 5 nfsnobody nfsnobody 220 12月 17 09:34 piece_d1001r1p5

drwx------. 5 nfsnobody nfsnobody 220 12月 18 09:34 piece_d1001r1p6

drwx------. 5 nfsnobody nfsnobody 220 12月 19 09:35 piece_d1001r1p7

drwx------. 5 nfsnobody nfsnobody 220 12月 20 11:06 piece_d1001r1p8

drwx------. 5 nfsnobody nfsnobody 105 12月 20 11:06 piece_d1001r1p9

drwx------. 2 nfsnobody nfsnobody 4096 12月 20 11:06 pieces

drwx------. 2 nfsnobody nfsnobody 39 12月 12 09:32 rounds

[root@localhost ~]# ll /data/nfs_server/backup/archive/piece_d1001r1p7/*

-rw-------. 1 nfsnobody nfsnobody 39898 12月 19 09:35 /data/nfs_server/backup/archive/piece_d1001r1p7/file_info.obarc

-rw-------. 1 nfsnobody nfsnobody 76 12月 19 09:35 /data/nfs_server/backup/archive/piece_d1001r1p7/piece_d1001r1p7_20241218T093218_20241219T093217.obarc

-rw-------. 1 nfsnobody nfsnobody 179 12月 19 09:35 /data/nfs_server/backup/archive/piece_d1001r1p7/single_piece_info.obarc

-rw-------. 1 nfsnobody nfsnobody 855 12月 18 09:34 /data/nfs_server/backup/archive/piece_d1001r1p7/tenant_archive_piece_infos.obarc

/data/nfs_server/backup/archive/piece_d1001r1p7/checkpoint:

总用量 4

-rw-------. 1 nfsnobody nfsnobody 200 12月 18 09:34 checkpoint_info.0.obarc

-rw-------. 1 nfsnobody nfsnobody 0 12月 19 09:34 checkpoint_info.1734571937996434248.obarc

/data/nfs_server/backup/archive/piece_d1001r1p7/logstream_1:

总用量 4

-rw-------. 1 nfsnobody nfsnobody 132 12月 19 09:35 file_info.obarc

drwx------. 2 nfsnobody nfsnobody 57 12月 19 07:42 log

drwx------. 2 nfsnobody nfsnobody 39 12月 18 09:34 schema_meta

/data/nfs_server/backup/archive/piece_d1001r1p7/logstream_1001:

总用量 160

-rw-------. 1 nfsnobody nfsnobody 39803 12月 19 09:35 file_info.obarc

drwx------. 2 nfsnobody nfsnobody 77824 12月 19 09:31 log

1 个赞

Elm

2024 年12 月 23 日 09:33

#17

老师,如何通过归档恢复clog给oms固定数据传输位点?

1 个赞

淇铭

2024 年12 月 23 日 18:16

#22

系统租户下查看 获取当前ROUND最早可消费的归档日志位点

1 个赞

之前让你查询的语句 可以看到

之前让你查询的语句 可以看到