【 使用环境 】测试环境

【 OB or 其他组件 】OB集群

【 使用版本 】4.3.1

【问题描述】分区表的leader分布是根据节点平均分配吗?可以自定义分配规则吗?

【复现路径】

【附件及日志】

是要仅仅修改这一个表的leader分布么

我想了解下,这个leader是根据什么规则分布的

根据文档中的信息以及您提供的环境和版本信息,关于分区表的Leader分布,OceanBase数据库的Leader分布并非简单地根据节点平均分配。在OceanBase集群中,Leader的分布受到多种因素的影响,包括但不限于负载均衡策略、分区策略以及系统健康状况等。OceanBase设计有负载均衡模块,该模块旨在优化资源使用并确保数据访问的高效性。

-

默认分布:默认情况下,OceanBase会尝试通过其内置的负载均衡策略来自动管理Leader的分布,以达到数据和负载在各个节点之间的均衡。这意味着虽然不保证绝对的“平均”,但系统会动态调整以接近最优分布。

-

自定义分配规则:虽然直接自定义Leader分配规则的功能不是直接暴露给用户的,但您可以通过影响分区策略间接影响Leader的分布。例如,通过精心设计分区键和分区函数,可以在一定程度上引导数据(及相应的Leader)倾向于分布在特定的节点或区域。此外,OceanBase支持的分区类型(如Range、List、Hash等)能够灵活地根据业务需求组织数据,间接影响Leader的分布格局。

-

负载均衡与调整:在V4.3.1版本中,OceanBase采用的日志流(Log Stream, LS)架构,副本以日志流为粒度分布,每个日志流承载多个分区。负载均衡主要集中在LS层面,先实现LS的均衡,进而影响其上的分区分布。这意味着,虽然直接干预每个分区Leader的分配较为复杂,但通过运维操作和配置调整,可以促进整个集群的负载更加均衡。

综上所述,分区表的Leader分布不是简单地基于节点平均分配,但OceanBase提供了机制来确保整体的负载均衡和优化数据分布。如果您有特定的分布需求或遇到分布不均的问题,建议查阅官方文档关于负载均衡和分区策略的部分,或者联系OceanBase技术支持获取更具体的指导和建议。

具体信息可参考以下文档:

比如我一个集群,3个节点,3台节点的容量不一致,一个1T,一个500G,一个128G,数据存储打散到各个节点,规则是怎么样的?随机吗?平均吗?还是根据容量来的?

根据OceanBase数据库的设计原则和运作机制,数据在不同容量的节点上的分布并不是随机的,也不是简单地追求每个节点上的数据量平均。OceanBase在处理这类场景时,会更倾向于根据节点的容量和当前的负载情况来智能地分布数据,以达到整体的负载均衡和资源优化。以下是几个关键点,解释了在这种情况下数据分布的规则:

-

资源感知的负载均衡:OceanBase数据库具备资源感知的负载均衡能力,意味着系统在进行数据分布和副本放置时,会考虑到各个节点的存储容量、CPU、内存等资源状况。尽管直接根据磁盘容量来分配数据比例的细节未在文档中明确阐述,但系统的目标是确保整体的资源利用率和数据访问效率。因此,理论上,拥有更大存储容量的节点可能会被分配更多的数据,以充分利用其存储资源,同时保持整个集群的负载均衡。

-

分区与副本策略:数据在OceanBase中是按照分区进行管理的,每个分区可能有多个副本以确保高可用性。分区的分布会遵循一定的策略,旨在优化数据访问和存储。虽然分区的初始分布可能基于简单的规则(如轮询或根据分区键),但长期运行中,系统会通过自动的负载均衡机制动态调整,使得数据分布更加合理,这包括在不同容量的节点间迁移数据以平衡存储使用。

-

优先级与Primary Zone:用户可以通过设置

primary_zone来影响数据的初始分布,但这主要是针对Zone级别的策略,而非直接针对单个节点的容量。尽管如此,合理的Zone配置可以间接帮助数据倾向于存储在资源更丰富的节点上。 -

动态调整与优化:随着时间推移和数据增长,OceanBase的管理工具和SQL命令允许对数据分布进行调整,以应对节点资源变化的情况。例如,如果发现某些大容量节点并未充分利用,可以通过运维操作促使系统重新评估并调整数据分布。

综上所述,尽管没有直接文档说明针对不同容量节点的具体分配算法,但OceanBase的智能负载均衡机制会倾向于根据节点的实际容量和当前负载情况动态调整数据分布,以达到高效利用资源和维持系统稳定性的目的。如果需要更精确的控制或了解当前集群的具体分布策略,建议使用OceanBase的管理界面或命令行工具查询集群状态,并咨询OceanBase技术支持获取定制化的建议。

具体信息可参考以下文档:

三个节点如果是三个zone 那么集群可用最大容量就是128G,每个zone都会有租户的一个副本集存在。

如果为一个zone,则需要看租户的unit_num设置个数了

一个zone,也是3个节点

如果三个节点存储不同的话,后续可能会产生问题,分区均衡优先级是:分区属性对齐>数量>存储。

建议还是尽量使用同样存储大小的节点

所以3个节点要是不同的机器的话,是按照最差配置那台的标准来对齐的吗?

硬盘容量和内存都是按照最差那台配置的来?然后另外2台也对齐这个最差配置的

租户规格包括内存和CPU,这个需要跟最低配置的对齐,存储方面这个我先去问问其他同学关于负载均衡优先级的信息

谢了!!

那这么说的话,我最差的那台机器,8G内存怕是带不动了啊?感觉这个内存要求还是不低的

估计能创建个4-6G内存的租户 ![]()

可以创建租户设置unit_num=1,仅让他在规格最大的机器上

哦哦,这就有点类似单机了,这个租户

你现在想用的应该是单zone3台机器,分布式的为1-1-1 三个zone

没太看明白!

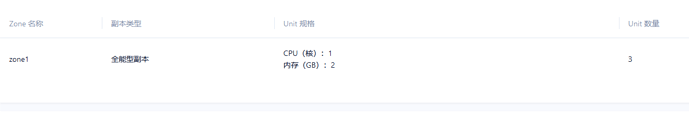

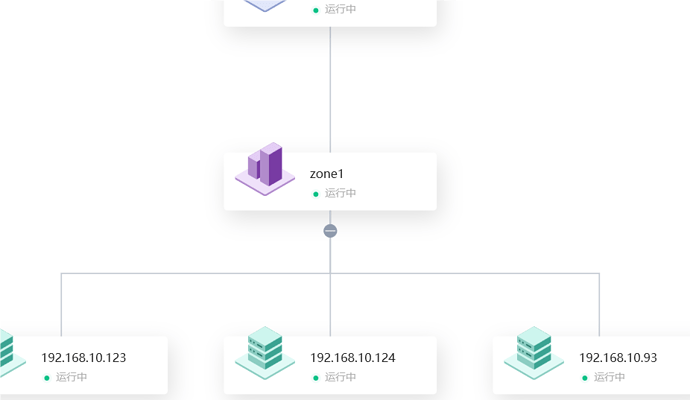

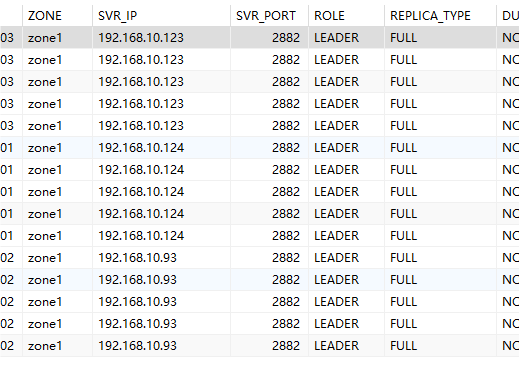

我现在是这样

我其实目前就是这样的,3台机器,3台机器规格是不同的,其中有一台是配置高点(内存和硬盘容量都比较大),另外两台是配置稍微差点(8G,硬盘容量少点),我目前就是想分布式部署,让数据库最大化利用上资源。我只要有一个租户用就行了,现在就是有点不太理解ob的一个资源利用率分配。目前看来cpu和内存确实是按照最差的那台机器为标准分配的,容量还不清楚

刚才咨询了负载均衡的相关同学,当前没有适配这种磁盘规格不同的集群。均衡都是按相同规格搞的,后面有可能大磁盘没法充分利用。