码到成功

2023 年3 月 8 日 22:04

#1

【 使用环境 】测试环境

【 OB or 其他组件 】

【 使用版本 】

【问题描述】清晰明确描述问题

【复现路径】问题出现前后相关操作

【问题现象及影响】

热海

2023 年3 月 9 日 10:38

#3

码到成功

2023 年3 月 9 日 12:29

#4

可能是我问题分类的错误,我是oblogProxy的问题,不是OBProxy的,所以您的链接未能解决我的问题

cdc是对增量数据变化的捕获,obcdc 衍生出了 oblogproxy

川粉

2023 年3 月 9 日 14:50

#5

在您描述的场景里,我推测的可能原因是:部署到同一台机器上时,两者使用了相同版本的依赖库,而在分开部署时,oblogproxy 会自动下载最新的依赖,结果上造成了依赖版本不对,因此出现了问题。

OceanBase 社区版 4.0 推荐的搭配是 oblogproxy 1.1.0,建议您使用压缩包形式进行部署,可以避免依赖版本冲突的问题。在下边任意链接选择 1.1.0 for 4x

https://www.oceanbase.com/softwarecenter

码到成功

2023 年3 月 9 日 15:03

#6

我想知道,分开部署之后 oblogproxy的配置/conf/conf.json 和 接受消息的端配置及参数是否需要调整?

ObReaderConfig config = new ObReaderConfig();

// OB库

config.setRsList("192.168.1.41:2882:2881;");

// 设置用户名和密码(非系统租户)

config.setUsername("test@mysql_tenant");

config.setPassword("test");

// 设置启动位点(UNIX时间戳,单位s), 0表示从当前时间启动。

config.setStartTimestamp(0L);

// 设置订阅表白名单,格式为:tenant.db.table, '*'表示通配.

config.setTableWhiteList("mysql_tenant.*.*");

//oblogproxy服务地址,创建实例.

LogProxyClient client = new LogProxyClient("192.168.1.99", 2983, config);

码到成功

2023 年3 月 9 日 15:49

#7

另外:

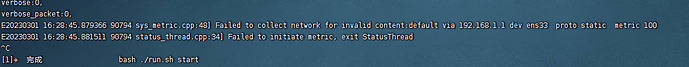

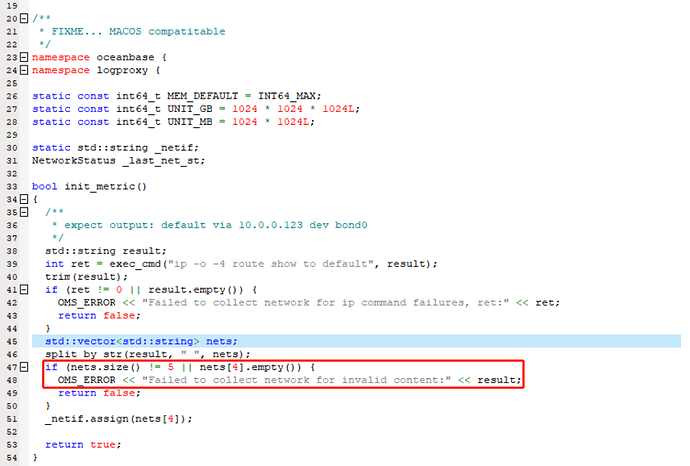

大概看了下源码,物理机和虚拟机的返回不一样

虚拟机中"ip -o -4 route show to default "的返回:

码到成功

2023 年3 月 9 日 18:11

#10

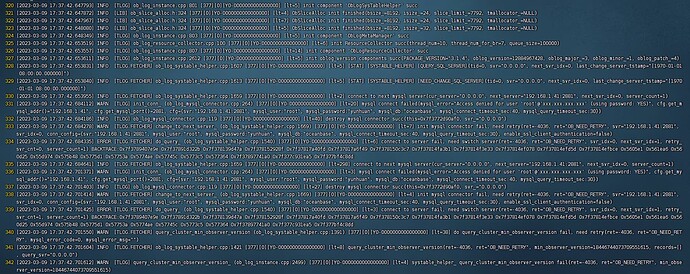

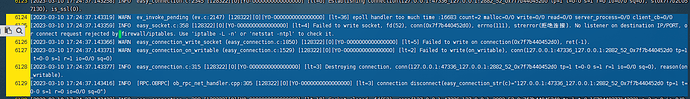

客户端启动后,代理的oblogproxy/run/{client-id}/log/liboblog.log 有warn和error,

ERROR [TLOG.FETCHER] do_query_ (ob_log_systable_helper.cpp:1540) [377][0][Y0-0000000000000000] [lt=5] connect to server fail, need switch server(ret=-4036, ret=“OB_NEED_RETRY”, svr_idx=0, next_svr_idx=1, retry_svr_cnt=0, server_count=1)

码到成功

2023 年3 月 9 日 23:59

#11

通过root@sys链接后不再有Access denied,程序能收到心跳,但是增量数据采集不到

三木大大

2023 年3 月 10 日 23:25

#14

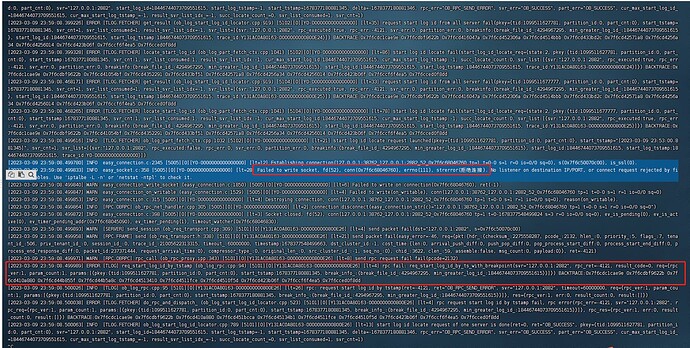

这里有RPC_SEND_ERROR的报错,可以先看下oblogproxy所在虚拟机能否与OB的SQL端口和RPC端口联通

码到成功

2023 年3 月 11 日 17:20

#15

另外我想问,日志里代理服务器上为什么会访问127.0.0.1:2882 这个是ob的,代理服务器本地确实没有

三木大大

2023 年3 月 12 日 11:31

#16

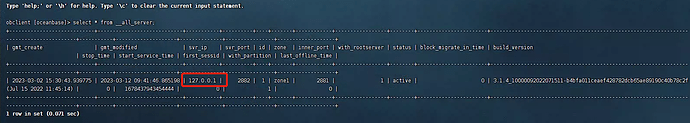

oblogproxy访问的机器ip是从ob的__all_server表里获取的,可以看下为什么表里记录的是127.0.0.1

三木大大

2023 年3 月 13 日 15:00

#18

可以尝试把oblogproxy部署到OB机器上,应该能临时解决这个问题。要根本解决的话,需要定位__all_server表中记录的是127.0.0.1(可能是选择的网卡原因?)

码到成功

2023 年3 月 13 日 18:19

#19

1、部署在OB机器上可以采集的

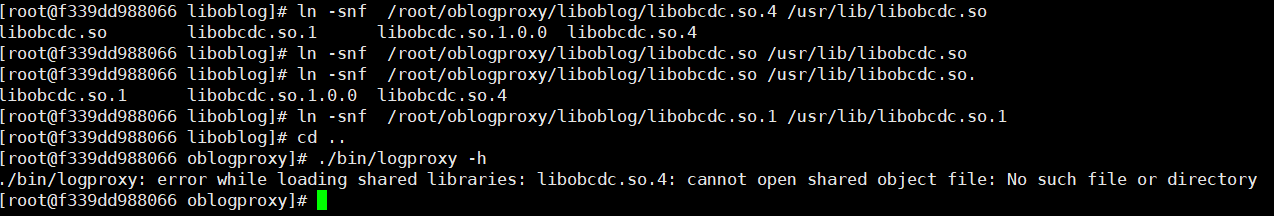

你好 我下载了此压缩包, 无法使用logproxy, 我将压缩包中的二进制文件链接到了/usr/lib下, 但是还是不行, 我哪里没做对吗

三木大大

2023 年4 月 29 日 13:21

#21

这个报错的原因是找不到libobcdc.so.4这个动态库,可以执行

1 个赞